GPU-Engpässe wandern: Von Chips zu Strom und Kühlung – Der neue Albtraum der KI-Rechenzentren

Haben Sie sich je gefragt, warum der KI-Boom trotz Milliardeninvestitionen ins Stocken gerät? Microsoft-CEO Satya Nadella hat es kürzlich klar formuliert: Der Engpass bei Nvidia-GPUs ist vorbei – das wahre Hindernis sind nun Stromnetze und fertige Rechenzentren. Während Nvidia mit Rekordumsätzen glänzt, kämpfen Cloud-Anbieter wie CoreWeave und Lambda mit Margendruck durch Lieferverzögerungen, explodierende Energiekosten und kreative Finanzierungsmodellen. Gewinner könnten Nvidia und Energieversorger sein, Verlierer die reinen Cloud-Provider.

Der Wandel der Engpässe: Von GPUs zu Energie und Infrastruktur

Satya Nadella von Microsoft bestätigt einen Paradigmenwechsel: Früher waren Nvidia-GPUs der Flaschenhals, heute fehlen warme Hüllen – also angeschlossene Rechenzentren mit Strom. Lokale Netzbegrenzungen und Genehmigungsverzögerungen bremsen Projekte massiv. Dieser Shift hat weitreichende Folgen für Rechenzentrumsanbieter.

In China explodieren indes GPU-Preise durch US-Sanktionen: Die RTX 5090-Serie stieg innerhalb eines Monats um über 10 Prozent, da KI-Firmen auf Consumer-Karten ausweichen müssen. Dies verdeutlicht regionale Verwerfungen, die globale Lieferketten belasten.

- Warzeiten für High-End-GPUs wie H100: 6-12 Monate, Preise 25.000-40.000 Dollar pro Einheit.

- Speicher-Krise verschärft Grafikkarten-Preise ab Ende 2025 durch TSMC-Auslastung.

- Nvidia-Data-Center-Umsatz: 51,2 Milliarden Dollar im Q3 2025/26, +66 Prozent – getrieben von Blackwell-Chips.

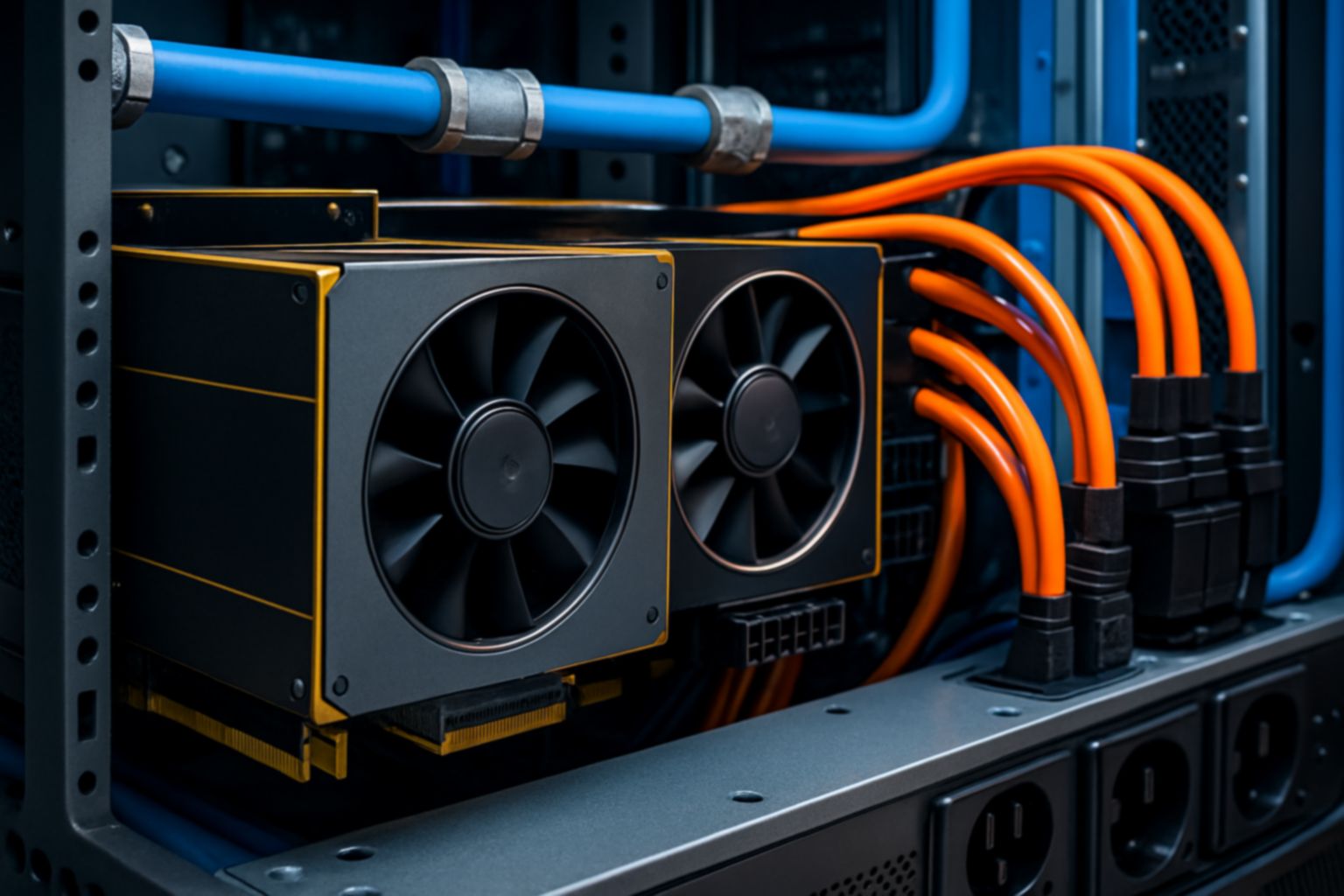

Kühlung als unsichtbarer Kostenfaktor

KI-Workloads erzeugen enorme Abwärme. Kühlung frisst bis zu 55 Prozent des Energieverbrauchs. Herkömmliche Systeme scheitern, Flüssigkeitskühlung wird Standard – teurer, aber unvermeidbar. Nvidia-Blaupausen wie DSX nutzen digitale Zwillinge, um Gigawatt-Datacenter effizient zu planen.

Kreative Finanzmodelle: Nvidias Round-Trip-Strategie

Nvidia sichert Absatz durch unkonventionelle Deals. Bei CoreWeave garantiert Nvidia bis 2032 bis zu 6,3 Milliarden Dollar ungenutzter Kapazität abnehmen – ein Backstop für den Provider. Ähnlich mietet Nvidia GPUs von Lambda zurück, die sie zuvor verkauft hat: 18.000 Einheiten für 1,5 Milliarden Dollar.

Bei OpenAI plant Nvidia 100 Milliarden Dollar Investitionen plus Leasing von Vera-Rubin-Systemen mit 10 GW Leistung – Kosten: 500-600 Milliarden Dollar insgesamt. Dieses Modell pumpt Umsätze heute, verschiebt Kosten in die Zukunft und stützt Neocloud-Partner.

- Vorteil für Nvidia: Hohe Margen (stabil trotz Konkurrenz).

- Belastung für Cloud-Anbieter: Abhängigkeit von Nvidia-Finanzierung, Margendruck durch Mietkosten.

- OpenAI-Cashburn: 115 Milliarden Dollar bis 2029 durch Rechenkosten.

Konkurrenzdruck: Eigene Chips von Hyperscalern

Google-TPUs sind energieeffizienter und greifen Nvidias Datacenter-Monopol an (90 Prozent Umsatz). Alphabet, Amazon und Meta bauen eigene Silizium – langfristig weniger Nvidia-Abhängigkeit. Doch Blackwell-Nachfrage bleibt stark.

Auswirkungen auf Rechenzentrumsanbieter und Cloud-Märkte

Rechenzentrumsanbieter leiden unter neuen Limits: Strom, Kühlung und Genehmigungen. Startups sind ausgebremst, Giganten passen Pläne an. Nadellas Warnung vor Energiekollaps trifft zu: Chips stapeln sich ungenutzt.

Margendruck bei Cloud-Providern wächst durch hohe Vorinvestitionen und niedrige Auslastung. Neoclouds wie Crusoe experimentieren mit Weltraum-GPUs, doch Kühlkosten bleiben Hürde.

- Beispiel CoreWeave: Nvidia-Garantie stärkt Vertrauen, birgt aber Risiken.

- China-Markt: Zweckentfremdung von Gaming-GPUs treibt Preise.

- Nachhaltigkeit: Energieverbrauch entspricht Städten – Netze überfordert.

Investoren sollten Nvidia kaufen – starke Nachfrage und Ökosystem sichern Wachstum. CoreWeave und Lambda halten, aber verkaufen bei Margeneinbruch; Microsoft und Google als defensive Plays. Wirtschaft profitiert von Innovationen, leidet unter Energieengpässen: Höhere Strompreise belasten Haushalte, doch KI-Treiber schaffen Jobs in Bau und Erneuerbaren. Zukünftig erwarten Gigawatt-Fabriken mit Flüssigkühlung und Fusionsenergie; Sanktionen fragmentieren Märkte, eigene Chips reduzieren Monopole bis 2030.

Keywords: GPU-Engpässe, Nvidia-Finanzierung, Stromnetz-Limit, KI-Rechenzentren, Margendruck-Cloud

Kommentar abschicken