Nvidia zündet die nächste KI‑Chip-Stufe: Was Blackwell & Vera Rubin für Tech-Branche, Wirtschaft und Anleger bedeuten

Kaum ein anderes Unternehmen verkörpert den KI‑Boom so stark wie Nvidia. Mit der neuen Generation von KI‑Chips – allen voran der Blackwell‑Architektur und der angekündigten Vera‑Rubin‑Superchip‑Familie – verschiebt der Konzern erneut die Grenzen des technisch Machbaren. Während Rechenzentren ihre Bestellungen hochfahren und Analysten von einer neuen Welle an „AI Factories“ sprechen, preisen die Märkte ein künftiges Gewinnfeuerwerk ein: Die Nvidia‑Aktie kennt seit Monaten fast nur eine Richtung. Doch was steckt technologisch dahinter – und welche Chancen und Risiken ergeben sich für Anleger und die Gesamtwirtschaft?

Im Mittelpunkt steht die Frage: Wer profitiert von dieser neuen KI‑Chip‑Generation – und wessen Geschäftsmodell gerät unter Druck? Besonders interessant sind neben Nvidia selbst vor allem Cloud‑Hyperscaler, Rechenzentrumsbetreiber, Zulieferer im Halbleiter‑Ökosystem und jene Wettbewerber, die sich gegen den scheinbar unaufhaltsamen Marktführer stemmen müssen.

Die neue KI‑Welle: Blackwell, Blackwell Ultra und Vera Rubin

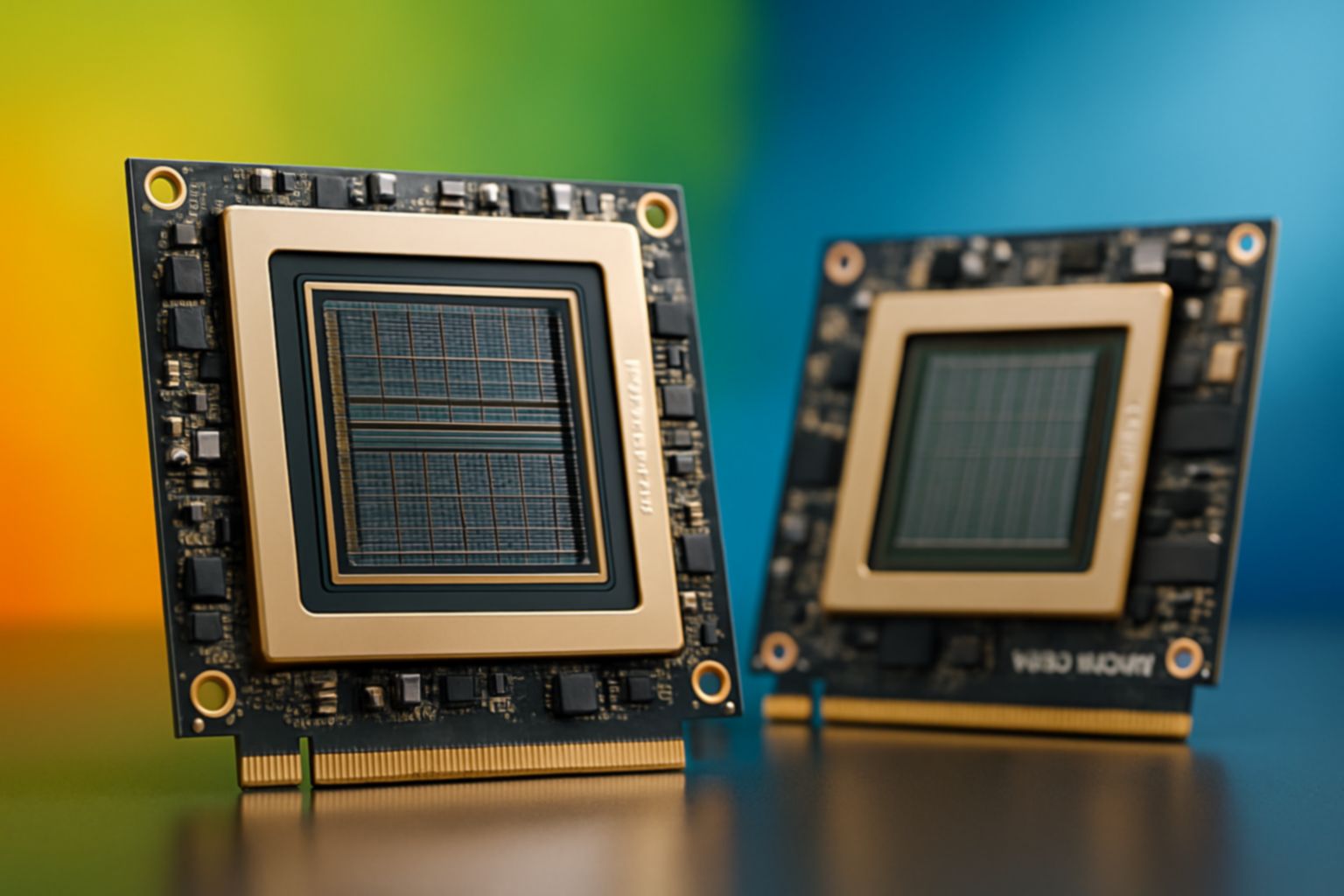

Nvidia nutzt die Bühne der GTC‑Konferenz 2025, um seine KI‑Roadmap aggressiv zu verdichten. CEO Jensen Huang kündigt mit Blackwell Ultra eine nächste Ausbaustufe der Blackwell‑Architektur an, die in der zweiten Jahreshälfte 2025 in den Markt kommen soll.[1] Blackwell Ultra soll im Vergleich zum aktuellen GB200‑System rund 1,5‑mal bessere FP4‑Inferencing‑Leistung, 1,5‑mal mehr Speicher und die doppelte Bandbreite liefern.[1] Für Rechenzentren heißt das: noch mehr Modelle, noch größere Kontexte, noch schnellere Inferenz – bei gleichem oder geringerem Platzbedarf im Rack.

Parallel dazu stellt Nvidia mit Vera Rubin eine gänzlich neue Generation von Superchips in Aussicht, die ab 2026/2027 ausgeliefert werden soll.[1] Die Vera‑Rubin‑Plattform kombiniert 88 maßgeschneiderte Arm‑basierte CPUs („Vera“) mit neuen GPUs („Rubin“). Laut Nvidia wird ein System mit Vera Rubin rund 3,3‑mal schneller sein als ein System mit Blackwell Ultra, während Rubin Ultra 2027 noch einmal nachlegt und die Leistung pro Rack auf bis zu 15 Exaflops steigert – verglichen mit einem Exaflop heutiger High‑End‑Systeme.[1][7]

Damit verschiebt Nvidia zum wiederholten Mal den Branchenmaßstab. Die Blackwell‑Architektur selbst adressiert vor allem jene Flaschenhälse, die sich im Zeitalter gigantischer Transformer‑Modelle zeigen: Speicherbandbreite, Energieeffizienz und das Handling niedriger Präzision (FP4/FP8) bei gleichzeitig hoher Modellgüte.[6] Die zweite Generation der Transformer Engine in Blackwell kombiniert optimierte Tensor Cores mit Software‑Stacks wie TensorRT‑LLM und NeMo, um Training und Inferenz großer Sprach‑ und Multimodalmodelle massiv zu beschleunigen.[6]

Von AI Factory bis Agenten‑Zeitalter: Nvidias strategisches Narrativ

Jensen Huang präsentiert all dies nicht als isolierte Chip‑Updates, sondern als Teil eines größeren Narrativs: der Entstehung globaler AI Factories. Datenzentren werden zu spezialisierten KI‑Fabriken, in denen Modelle wie Produkte mit hoher Taktung trainiert, verfeinert und ausgerollt werden. Die nächste Welle, so Huang, sei das Zeitalter des „agentic AI“ – KI‑Agenten, die eigenständig Aufgaben strukturieren, Teilprobleme lösen, Alternativen abwägen und Entscheidungen treffen.[1]

Um diese Vision zu untermauern, liefert Nvidia neben Hardware gleich auch die passende Software: Die Open‑Source‑Plattform Dynamo soll als eine Art Betriebssystem für KI‑Fabriken dienen und beschleunigte Inferenz und Reasoning‑Workloads um bis zu den Faktor 30 effizienter machen.[1] Gleichzeitig übernimmt „Mission Control“ die automatisierte Orchestrierung von GPU‑Clustern, während Llama‑Nemotron‑Modelle Unternehmen einen direkt nutzbaren Einstieg in reasoning‑fähige KI‑Modelle bieten.[1][4]

Der strategische Wissenspunkt dabei: Nvidia verschiebt sich weg vom reinen Chip‑Lieferanten hin zu einem integrierten KI‑Plattformanbieter – inklusive Hardware, Middleware, Modelle und Management‑Software. Das verschärft den Lock‑in‑Effekt für Kunden, erhöht Margenpotenzial und erschwert es Wettbewerbern, lediglich mit „vergleichbarer Hardware“ zu punkten.

Personal AI Supercomputing: Grace Blackwell auf dem Schreibtisch

Einen zweiten, häufig unterschätzten Innovationsschub markiert Nvidias Vorstoß in Richtung persönlicher KI‑Supercomputer. Unter dem Projektnamen DIGITS – und inzwischen im Markt als DGX Spark – bringt Nvidia ein System, das auf dem GB10 Grace Blackwell Superchip basiert und bis zu einen Petaflop KI‑Leistung bei FP4‑Präzision bereitstellt.[2][5][9] Zielgruppe sind Entwickler, Forscher und Unternehmen, die KI‑Modelle lokal entwickeln, fine‑tunen und testen wollen, ohne sofort auf ganze Rechenzentrums‑Cluster angewiesen zu sein.

Das System integriert eine Blackwell‑GPU mit aktuellen CUDA‑ und Tensor‑Cores auf einem System‑on‑a‑Chip mit Grace‑CPU und NVLink‑Anbindung.[5][9] TechCrunch beschreibt DGX Spark und die stärkere DGX Station als „Personal AI Supercomputers“, die es ermöglichen, KI‑Workloads von Edge‑Geräten über Workstations bis hin zu großen Clustern konsistent zu betreiben.[2] Partner wie Dell, HP, Lenovo und Asus sollen entsprechende Workstations in die Breite tragen.[2]

Damit öffnet Nvidia einen zusätzlichen Kanal jenseits der Hyperscaler: Unternehmen können kritische Modelle on‑premises entwickeln und betreiben, Datenschutz‑Bedenken mindern und zugleich die Abhängigkeit von Public‑Cloud‑Infrastruktur reduzieren. Für die Halbleiter‑ und OEM‑Industrie entsteht ein neuer, margenträchtiger Produktbereich im Spannungsfeld zwischen klassischer Workstation und Mini‑Rechenzentrum.

Consumer‑Impuls: RTX‑50‑Serie mit Blackwell‑Architektur

Parallel zum Rechenzentrums‑Fokus adressiert Nvidia auf Messen wie der CES 2025 auch den Massenmarkt: Laut Branchenanalysen führt der Konzern eine neue GeForce RTX‑50‑Serie ein, die auf der Blackwell‑Architektur basiert und sich an Gamer, Creator und Entwickler richtet.[4] Diese GPUs sollen rund 92 Milliarden Transistoren integrieren, bis zu 4.000 TOPS an KI‑Rechenleistung liefern und mit vier dedizierten AI‑Processing‑Units dreifache Performance gegenüber der Vorgängergeneration (Ada) bieten.[4]

Damit wird KI‑Beschleunigung nicht mehr nur zur Rechenzentrums‑Domäne, sondern sickert über Gaming‑GPUs, Creator‑Laptops und Developer‑Systeme in den Massenmarkt. Für Software‑Ökosysteme – von Spiele‑Engines bis zu Coding‑Assistenten – bedeutet das: KI‑Features können als Standardfunktion auf Consumer‑Hardware eingeplant werden, anstatt optionalen „High‑End‑Modus“ darzustellen.

Ökonomische Sprengkraft: Gewinner und Verlierer im KI‑Chip‑Zeitalter

Die Kapitalmärkte honorieren Nvidias Taktzahl: Der Konzern ist in den vergangenen Jahren zur Leitaktie des KI‑Booms geworden, und jede neue Chip‑Generation wird als Signal für weiteres Wachstum interpretiert. Technologisch ergibt sich eine klare Struktur von potenziellen Gewinnern und Verlierern.

Wer profitiert direkt?

Direkte Profiteure sind vor allem:

- Cloud‑Hyperscaler (Alphabet, Microsoft, Amazon): Sie können mit Blackwell‑ und Vera‑Rubin‑Systemen KI‑Services mit höherer Marge und größerer Leistungsdichte anbieten. Je mehr Rechenleistung pro Rack, desto besser lassen sich Flächen‑ und Energiekosten optimieren.

- Rechenzentrumsbetreiber und Colocation‑Spezialisten: Höhere Packungsdichte von Exaflops pro Rack erhöht den wirtschaftlichen Wert jedes Quadratmeters Datacenter‑Fläche.

- Halbleiter‑Zulieferer: Speicherspezialisten (HBM‑Hersteller), Foundries, Packaging‑Partner und Netzwerkspezialisten profitieren von steigenden Volumina und komplexeren Systemen.

- OEMs und Workstation‑Hersteller: DGX Spark & Co. schaffen neue Premium‑Produktlinien im Enterprise‑Segment.

Ein interessanter Wissenspunkt: Mit der Ankündigung von Vera Rubin und Rubin Ultra mit bis zu 15 Exaflops pro Rack definiert Nvidia den Exaflop nicht mehr als Singularität („der eine Exascale‑Supercomputer“), sondern als skalierbare Kennzahl für Standardracks.[1] Das verschiebt die Wahrnehmung von Supercomputing – von spektakulären Einzelsystemen hin zu industriell standardisierten Bausteinen für KI‑Fabriken.

Wer gerät unter Druck?

Unter Druck geraten vor allem:

- Direkte GPU‑Wettbewerber wie AMD und teilweise Intel: Sie müssen technologisch Schritt halten und gleichzeitig aggressiv bei Preis und Gesamtplattform (Software, Ökosystem) liefern, um gegen Nvidias Lock‑in anzukommen.

- Konventionelle CPU‑Rechenzentren: Klassische x86‑Server ohne Beschleuniger verlieren für KI‑Workloads rapide an Attraktivität, was die Nachfrage verschiebt und Investitionspläne vieler IT‑Abteilungen umkrempelt.

- Bestands‑ASIC‑Anbieter, deren Chips auf spezifische KI‑Modelle optimiert sind, riskieren obsolet zu werden, wenn generalistische Plattformen wie Blackwell/Vera Rubin schnell genug und flexibel genug bleiben.

Ein zentrales Risiko bleibt die Regulatorik: Exportkontrollen für Hochleistungs‑Chips in bestimmte Regionen, kartellrechtliche Bedenken angesichts Nvidias Marktstellung und mögliche Auflagen bei Energie‑ und Klimazielen können das Wachstum einbremsen. Zugleich wird für Kunden die Gefahr eines Single‑Vendor‑Risikos größer, je stärker sie ihre KI‑Infrastruktur auf einen Anbieter ausrichten.

Makroökonomische Dimension: KI‑Chips als Produktionsfaktor

Jenseits der Börse entfaltet Nvidias neue KI‑Generation eine erhebliche volkswirtschaftliche Wirkung. Drei Ebenen sind besonders relevant:

1. Produktivitätsgewinne durch agentische KI

Mit der Fokussierung auf agentische KI‑Systeme – also KI‑Agenten, die eigenständig Projekte strukturieren, Entscheidungen vorbereiten und Workflows ausführen – wird KI vom reinen Analyse‑Tool zum aktiven Produktionsfaktor.[1] Branchen wie Softwareentwicklung, Kundenservice, Logistikplanung, Forschung und sogar Teile des Managements können signifikante Effizienzsprünge erleben.

Dass Nvidia parallel ein Ökosystem reasoning‑fähiger Modelle (Llama Nemotron) anbietet und diese direkt auf die eigene Hardware optimiert, deutet darauf hin, dass KI‑Agenten nicht nur in Cloud‑Umgebungen, sondern auch in Unternehmensrechenzentren und Workstations laufen werden.[1][4] Für die Gesamtwirtschaft ergibt sich ein zweifacher Hebel: schnellere Innovation und sinkende Grenzkosten für digitale Services.

2. Energie‑ und Infrastrukturbedarf

Die Kehrseite der Exaflop‑Rennen ist der Energiebedarf. Zwar zielen Blackwell und Vera Rubin auf höhere Effizienz pro Recheneinheit, aber die absolute Menge an bereitgestellter Leistung steigt rapide.[1][6] Ganze Regionen ringen bereits heute mit der Frage, ob Strom‑, Wasser‑ und Netzinfrastruktur dem Ausbau von KI‑Rechenzentren standhalten.

Für die Wirtschaft bedeutet dies:

- Investitionsschub in Energie‑ und Datacenter‑Infrastruktur, von Stromnetzen bis zu Glasfaser‑Backbones.

- Strukturwandel in der Standortpolitik: Regionen mit günstiger Energie und stabilen Netzen ziehen verstärkt KI‑Investitionen an.

- Regulatorischen Druck zur Effizienzsteigerung und zum Einsatz erneuerbarer Energien.

3. Arbeitsmarkt und Wettbewerbsfähigkeit

Wenn KI‑Agenten einen wachsenden Teil kognitiver Aufgaben übernehmen, verschiebt sich die Qualifikationsnachfrage: Weg von Routine‑Tätigkeiten, hin zu Rollen, die KI orchestrieren, validieren und in Geschäftsprozesse integrieren. Länder und Unternehmen, die frühzeitig in KI‑Infrastruktur und ‑Know‑how investieren, können ihre Wettbewerbsfähigkeit deutlich erhöhen – insbesondere in wissensintensiven Branchen.

Gleichzeitig drohen Ungleichgewichte: Firmen ohne Zugang zu moderner KI‑Infrastruktur – oder ohne Kapital, sie aufzubauen – laufen Gefahr, technologisch abgehängt zu werden. Das gilt besonders für KMU in Branchen, die stark von Daten und Automatisierung abhängen.

Aktienanalyse: Kaufen, Halten, Verkaufen?

Aus Investorensicht ist die Kernfrage: Wie sollten die neuen Nvidia‑Chips in Anlageentscheidungen einfließen? Die Antwort hängt stark von der Position im Ökosystem ab.

Klarer Profiteur: Nvidia selbst

Nvidia bleibt der zentrale Hebel für das KI‑Hardware‑Thema. Die Roadmap bis 2027 – von Blackwell Ultra über Vera Rubin bis Rubin Ultra – verdeutlicht, dass der Konzern sein Tempo hoch hält und damit ein mehrjähriges Investitionsfenster für KI‑Infrastruktur bespielt.[1][7] Solange Nachfrage nach Training und Inferenz großer Modelle hoch bleibt, dürfte die Preissetzungsmacht für High‑End‑Chips bestehen.

Wesentliche Argumente, die für ein Kaufen/Halten sprechen:

- Technologische Führerschaft bei Beschleunigern und Software‑Stacks.

- Tiefe Integration in Cloud‑Ökosysteme und AI‑Factories.

- Ausbau des Marktes in Richtung Workstations/Personal Supercomputing.

Risiken – und damit Gründe, bei extremer Bewertung eher teilweise Gewinne mitzunehmen – sind:

- Regulatorische Eingriffe (Exportkontrollen, Wettbewerb).

- Stärkere Konkurrenz, vor allem durch spezialisierte Beschleuniger und Open‑Source‑Software, die die Hardware stärker „kommoditisieren“ könnte.

- Zyklische Investitionspausen im Rechenzentrumssektor nach Phasen massiver Ausgaben.

Hyperscaler & Datacenter‑Plattformen

Alphabet, Microsoft, Amazon profitieren stark von Nvidias Produktpalette, da sie KI‑Services als Plattform anbieten und mit höheren Margen rechnen können. Für sie ist die neue KI‑Generation ein Wachstumstreiber, aber nicht der alleinige: Strategische Eigenentwicklungen bei Chips (TPUs, custom ASICs) können die Abhängigkeit von Nvidia dämpfen.

Anlagestrategisch erscheinen die großen Cloud‑Plattformen als Halten bis moderates Kaufen: Sie sind diversifiziert, profitieren von KI auf Nachfrage‑ und Angebotsseite und bleiben zentrale Verteilpunkte der KI‑Ökonomie.

Wettbewerber und Zulieferer

AMD und Intel stehen im direkten Wettbewerb um KI‑Rechenzentren. Ihre Produkte werden von Nvidias Roadmap faktisch zu „Beweisstücken“: Gelingt es ihnen, einen technologischen oder preislichen Vorteil zu demonstrieren, kann dies überproportionale Kursgewinne auslösen; scheitern sie, drohen Marktanteilsverluste.

Hier bietet sich eher eine selektive Trading‑ und Halte‑Strategie an als ein unbedingter Kauf auf lange Sicht: Anleger sollten Produkt‑Roadmaps, Benchmarks und Großkunden‑Deals sehr genau verfolgen.

Zulieferer im Bereich HBM‑Speicher, Advanced Packaging und Netzwerk‑Hardware profitieren strukturell, sind aber stark von Zyklik und Kapazitätsausbau abhängig. Gut positionierte Player können interessante Kaufkandidaten sein, wenn Bewertungen im Vergleich zum Wachstum moderat bleiben.

Fallstudien: Wie Branchen Nvidia‑Chips einsetzen

Automobilindustrie und autonome Systeme

Auf der GTC 2025 hebt Nvidia Partnerschaften mit der Automobilindustrie hervor, etwa für selbstfahrende Systeme und robotergestützte Produktion.[3] Ein Beispiel ist ein präsentierter Robotik‑Prototyp („Blue“), der mit neuen Chips in Echtzeit komplexe Bewegungs‑ und Entscheidungsaufgaben löst.[3] Für OEMs in der Autoindustrie bedeutet das: KI‑Kompetenz verschiebt sich zunehmend in Richtung Software‑Stack und Daten, während Hochleistungs‑Hardware in Form von Standardplattformen von Nvidia und Partnern kommt.

Softwareentwicklung als KI‑Poweruser

Mit der Llama‑Nemotron‑Familie adressiert Nvidia explizit die rund 30 Millionen Softwareentwickler weltweit, die KI zur Verbesserung von Codequalität und Produktivität nutzen sollen.[4] In Verbindung mit DGX Spark entsteht ein Szenario, in dem Unternehmen eigene, lokal laufende Coding‑Assistenten trainieren und betreiben können – ein Gegenmodell zu rein cloudbasierten Tools. Das verstärkt die Nachfrage nach Workstation‑Klassen‑Hardware und könnte ein neuer, wiederkehrender Umsatzstrom werden.

Forschung, Gesundheitswesen, Finanzindustrie

Branchen mit datenintensiver Forschung – etwa Biotechnologie, Klimamodellierung oder Finanzmärkte – nutzen bereits heute GPU‑Cluster für Simulationen und Analysen. Mit niedrigpräzisen Formaten wie FP4 und FP8, die trotzdem hohe Genauigkeit liefern können, lassen sich Modelle häufiger iterieren und in Echtzeit auf neue Daten anpassen.[1][6] Das beschleunigt Innovationszyklen, erhöht aber auch den Druck, kontinuierlich in neue Hardwaregenerationen zu investieren.

Neue Wissenspunkte in der Debatte

Drei Aspekte, die in der öffentlichen Diskussion bislang tendenziell unterschätzt werden, verdienen besondere Beachtung:

- Standardisierung von Exaflops: Mit Rubin Ultra und 15 Exaflops pro Rack verschiebt Nvidia Supercomputing von der Einzelfall‑Show in die Serienproduktion. Das könnte die Eintrittsbarrieren für Länder und Unternehmen senken, die bisher keine nationale Top‑1‑Supermaschine betreiben konnten, aber nun modulare Exaflop‑Racks einkaufen.

- Personal AI‑Supercomputing als Talentmagnet: Unternehmen, die Entwicklern DGX‑Spark‑Klassen‑Hardware am Arbeitsplatz bieten, haben einen klaren Recruiting‑Vorteil. Der Kampf um KI‑Talente wird damit auch ein Wettbewerb um lokale Rechenleistung, nicht nur um Gehälter.

- Verschiebung der Machtbalance in der IT: Die Kombination aus Hardware‑Roadmap, Software‑Stack und Modellangebot verschiebt die Macht von klassischen Betriebssystem‑ und Datenbankanbietern hin zu KI‑Plattformbetreibern. In vielen Unternehmen wird Nvidia‑kompatible Infrastruktur zur „neuen Basisplattform“, auf der andere IT‑Entscheidungen aufsetzen.

Seriöse Einblicke in diese Entwicklung liefern etwa Berichte aus der Rechenzentrumsbranche, die GTC‑Ankündigungen in den größeren Kontext von AI‑Factories und Infrastrukturanforderungen einordnen, sowie die offiziellen Produktankündigungen zu DGX Spark und GB10 Superchips. Einen Blick auf die Implikationen für Entwickler und Edge‑Computing bieten zudem Beiträge wie der von TechCrunch zu persönlichen KI‑Supercomputern.

Für Anleger ergibt sich daraus ein klares Bild: Nvidia bleibt die Schlüsselfigur im KI‑Hardware‑Ökosystem, doch der Bewertungsrahmen ist ambitioniert und verlangt Disziplin. Wer heute einsteigt oder Positionen ausbaut, sollte dies mit einem mehrjährigen Horizont tun und sich der Zyklik im Rechenzentrumssektor bewusst sein. Die Aktie bleibt aus heutiger Sicht ein Kauf‑ bis Haltekandidat, während zuliefernde Spezialisten als Hebel auf das Thema dienen können. Dagegen erscheinen traditionelle Rechenzentrums‑Betreiber ohne klare KI‑Strategie sowie Anbieter rein CPU‑basierter Infrastrukturen eher als strukturelle Verlierer und damit tendenzielle Verkaufskandidaten.

Volkswirtschaftlich bringen Blackwell, Vera Rubin und personalisierte KI‑Supercomputer enorme Chancen für Produktivität und Innovation, aber auch erhebliche Herausforderungen in Energieversorgung, Regulierung und Arbeitsmarkt. Kurz‑ bis mittelfristig ist mit weiter explodierenden Investitionen in KI‑Infrastruktur zu rechnen; langfristig dürfte sich der Markt konsolidieren, sobald agentische KI‑Workloads stabiler werden und Effizienzgewinne einen Teil des Hardwarehungers ausgleichen. Für die nächsten Jahre spricht vieles dafür, dass sich der Trend eher beschleunigt als verlangsamt – mit Nvidia an der Spitze und einem ganzen Ökosystem, das um die besten Positionen im Zeitalter der KI‑Fabriken ringt.

Kommentar abschicken